默认以及按照好了Hadoop的环境和spark环境以及idea环境。这是上面代码中编写的输出路径。不进行此步骤的话在服务器运行会出错。表示主类入口,就是上图中的主类是。信息,等待几秒后即可关闭。,运行成功后出现红色...

”spark jar“ 的搜索结果

spark相关jar包

标签: spark

spark相关jar包

一,spark jar包加载顺序 1,SystemClasspath – Spark安装时候提供的依赖包,通常是spark home目录下的jars文件夹 【SystemClassPath】 2,Spark-submit --jars 提交的依赖包 【UserClassPath】 3,Spark-submit ...

提供在Spark上跑Xgboost模型需要的 Jar包及Python接口文件

网址http://spark.apache.org/downloads.html

I would like to call spark jar from java (to run spark process on yarn), and try to use this link code.It looks fit in my case, but I need to pass hashmap and some java values to spakr jar. Is it able...

允许Yarn在节点上缓存必要的spark依赖关系jar,这样每次应用程序运行时都不需要分发它。 在Hive 2.2.0之前,将spark-assembly jar上传到hdfs文件(例如:hdfs:// xxxx:8020 / spark-assembly.jar)并在hive-...

spark 最新技术架包,具体说名请找度娘。知道的人可以下载

hue中对spark任务的支持,是靠oozie支撑的。文档中提供了如何在hue中提交spark作业的操作步骤。

https://github.com/apache/hbase-connectors/tree/master/spark mvn -Dspark.version=2.4.4 -Dscala.version=2.11.7 -Dscala.binary.version=2.11 clean install

今天在使用中DataFrame往Mysql中插入RDD,但是一直报出以下的异常次信息:[[emailprotected] ~]$ bin/spark-submit --master local[2]--jars lib/mysql-connector-java-5.1.35.jar--class spark.sparkToJDBC ./spark...

都说spark是scala写的,是不是就是指这些jar包是scala编译出来的class组成的?

2,配置好下面的脚本,其中--driver-class-path要选择mysql的jar包所在的目录,另外有博客说可以在spark-env指定 export SPARK_CLASSPATH=$SPARK_HOME/lib/mysql-connector-java-5.0.8-bin.jar ,注意配置了--driver...

在spark里面使用jar包运行java项目

SparkJavaDemo 一个使用 java spark 框架的演示应用程序。

java打包spark jar包访问hive数据源

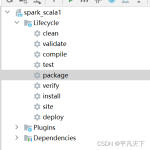

主要是介绍windows环境下提交并执行spark的jar包流程及注意事项,linux环境提交步骤类似且更直观; 2. 步骤 2.1 打包 我是直接用idea打包,没有用maven。 项目根目录右键 -> Open Module Settings -> ...

spark jar 本非方式运行 首先我们通过帮助命令来看spark 如何提交执行jar包 spark-submit --help spark-submit 详细参数说明 --master master 的地址,提交任务到哪里执行,例如 spark://host:port, yarn, ...

mongodb-spark官方连接器,运行spark-submit --packages org.mongodb.spark:mongo-spark-connector_2.11:1.1.0可以自动下载,国内网络不容易下载成功,解压后保存到~/.ivy2目录下即可。

使用spark-shell 或 spark-sql时(On Yarn)也有同样问题,导致启动很慢,物理机环境启动实测花费了28秒。再次启动spark-shell已经没有那句提示,打开时间为20秒,快了8秒。如果是spark集群,如HDP、,需从页面...

ES-Spark插件,使用该插件可以使用Spark向ES插入数据或者使用Spark读取ES的数据

同时,经过两天的学习,将使用本地spark-submit命令行的方式远程提交sparkJar到yarn集群的配置方法贴出: 分如下步骤: 一: 首先需要拷贝集群中的hadoop根目录机器根目录下的bin/ conf/目录到本地。 bin/目录是为了...

打包打包文件:File-->&...选择 From module with dependices 点击Output Layout 看看是否没有第三方jar包,因为你使用spark集群环境,所以你不需要第三方jar包 重新build:Build...

推荐文章

- 什么是ABA问题及ABA问题的解决方法。-程序员宅基地

- muduo库的Singleton类剖析_muduo网络库中的sinleton类是干嘛的-程序员宅基地

- attach java_【JAVA新生】nio attach引发的问题-程序员宅基地

- 位掩码(bitmask)在windows 串口事件驱动中的应用_windows返回bitmask的函数-程序员宅基地

- 【STL】stack & queue & priority_queue {栈,队列,优先级队列的介绍及使用;仿函数/函数对象;容器适配器,双端队列deque}_容器link、队列、栈、优先队列、bitset的使用方法-程序员宅基地

- Java泛型——限制可用类型_java 泛型 限制类型-程序员宅基地

- 冲刺港股IPO,速腾聚创「承压」-程序员宅基地

- C++中istringstream、ostringstream、stringstream详细介绍和使用_c++ istringstream-程序员宅基地

- Java面试之JUC系列: 阻塞队列详细解析_java实现阻塞队列面试-程序员宅基地

- WebUploader 大文件上传解决方案(500M以上)_webuploader 大小限制-程序员宅基地